tg-me.com/ds_interview_lib/795

Last Update:

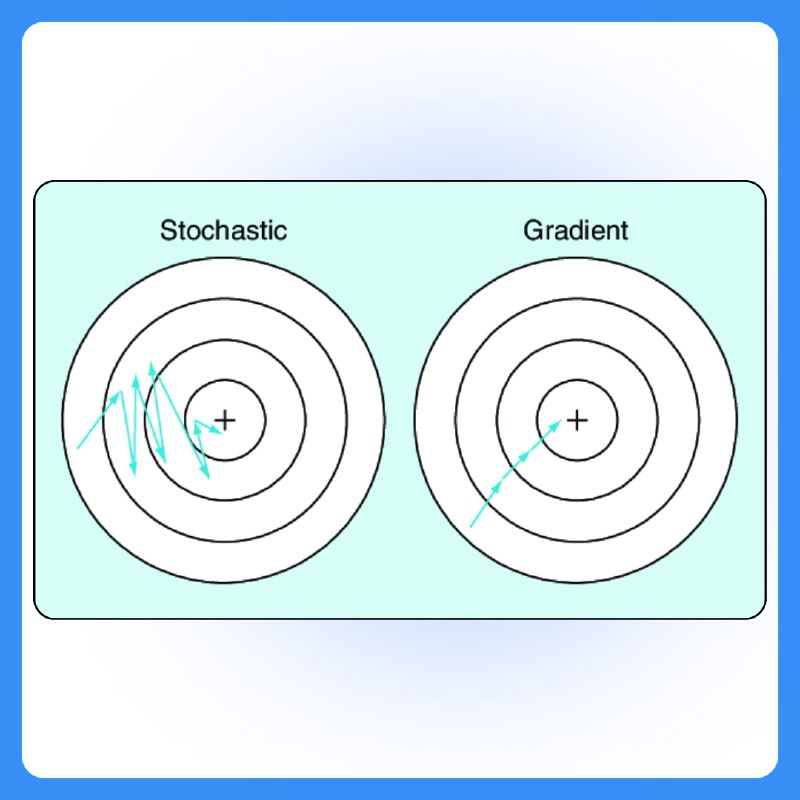

⤵️ Чем отличается метод градиентного спуска от стохастического градиентного спуска?

▪️ Метод градиентного спуска (Gradient Descent) — это оптимизационный алгоритм, который используется для минимизации функции потерь, обновляя параметры модели в направлении отрицательного градиента функции потерь. В каждом шаге используется весь обучающий набор данных для вычисления градиента.

▪️ Стохастический градиентный спуск (SGD) — это модификация, в которой градиент вычисляется только по одному случайно выбранному примеру данных на каждом шаге. Это делает процесс обучения быстрее, но более шумным.

Основное различие: градиентный спуск использует все данные, что делает его более точным, но медленным, а стохастический градиентный спуск быстрее, но может колебаться вокруг минимума из-за случайных обновлений.

BY Библиотека собеса по Data Science | вопросы с собеседований

Share with your friend now:

tg-me.com/ds_interview_lib/795